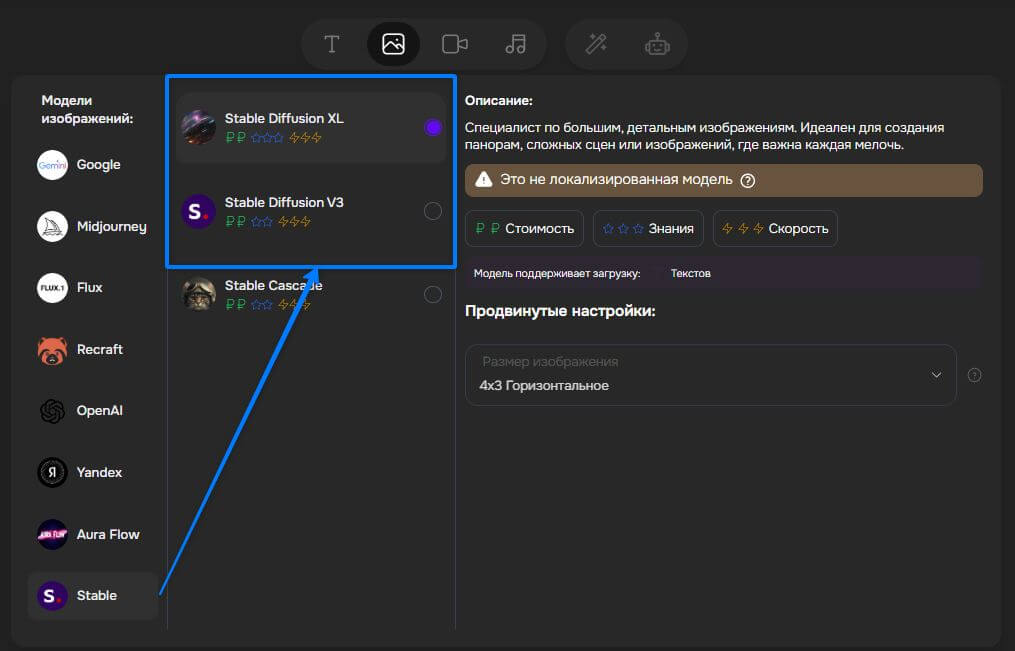

Нейросети для генерации картинок стали обыденностью, но большинство работает только через платную подписку. Stable Diffusion — исключение: открытый код, бесплатный запуск на своём компьютере, полный контроль над настройками.

За три года модель превратилась в стандарт для дизайнеров и разработчиков игр благодаря тысячам расширений и активному сообществу. Разбираем, как установить SD, настроить генерацию и использовать продвинутые инструменты вроде ControlNet и LoRA.

Что такое Stable Diffusion и чем она выделяется

Stable Diffusion — это нейросеть, которая создаёт картинки по вашему текстовому описанию. Напишите «кот в космосе» — получите изображение кота в скафандре на фоне звёзд.

Главное отличие от других генераторов — она полностью открыта. Вы можете скачать её к себе на компьютер и запускать сколько угодно раз бесплатно. Midjourney и DALL·E работают только через платную подписку в облаке.

Технически это латентная диффузионная модель. Она работает в сжатом пространстве, а не рисует каждый пиксель — поэтому генерирует быстрее и требует меньше видеопамяти.

Почему стала стандартом

Лицензия CreativeML Open RAIL-M позволяет использовать модель в коммерческих проектах. Ограничения есть только на запрещённый контент — нельзя создавать дипфейки известных людей или поддельные логотипы брендов.

Открытый код породил тысячи расширений. Интерфейсы AUTOMATIC1111 и ComfyUI дают полный контроль над параметрами — вы настраиваете шаги генерации, выбираете алгоритмы, загружаете свои модели. В закрытых сервисах такой свободы нет.

Для дизайнеров это означает независимость — запустили локально и работаете без ограничений по количеству картинок.

От SD 1.4 до SD 3.5: эволюция за три года

SD 1.4 — старт в августе 2022

Первая публичная версия генерировала картинки размером 512 × 512 пикселей. Качество было средним — руки часто выглядели странно, текст получался нечитаемым. Зато модель запускалась на обычных игровых видеокартах.

Именно открытость породила волну модификаций. Энтузиасты создали сотни улучшенных версий — для аниме, реалистичных портретов, архитектуры.

SDXL 1.0 — скачок в июле 2023

Разрешение выросло до 1024 × 1024 пикселей. Анатомия персонажей стала правдоподобнее, текст на картинках — читаемее. Модель научилась понимать сложные описания с несколькими объектами.

Требования к железу тоже выросли — для комфортной работы нужна видеокарта с 8 ГБ памяти.

SD 3 — новая архитектура в феврале 2024

Переход на Multimodal Diffusion Transformer улучшил понимание текста. Модель стала точнее передавать детали из описания — если вы просите «красную шляпу на левом персонаже», она не перепутает цвет или позицию.

Орфография в генерируемых надписях стала почти безошибочной.

SD 3.5 — актуальная версия июня 2025

Типографика теперь на уровне профессионального дизайна. Встроенный пакет ControlNet позволяет контролировать позу, глубину, контуры. API обновляется автоматически.

Тесты показывают паритет с Imagen 3 от Google по точности передачи текста.

Совместимость сохранена

Все версии поддерживают LoRA и чекпойнты от предыдущих моделей. Вы можете взять наработки для SD 1.5 и использовать их в SDXL с минимальными доработками. Это упрощает переход на новые версии.

Под капотом: как работает диффузионная модель

Stable Diffusion не рисует пиксель за пикселем. Она берёт случайный шум — как помехи на старом телевизоре — и постепенно превращает его в осмысленное изображение.

Процесс идёт шагами. На каждом шаге модель убирает часть шума, приближаясь к финальной картинке. Это называется DDPM-цикл — модель обучена предсказывать, какой именно шум убрать.

Ваше текстовое описание задаёт направление. CLIP-энкодер переводит слова «кот в космосе» в числа, которые подсказывают модели, куда двигаться при удалении шума.

Три главных детали

UNet работает в сжатом пространстве, а не с полным разрешением. Это экономит видеопамять — картинка 1024×1024 обрабатывается как компактный массив чисел.

VAE превращает эти числа обратно в обычную RGB-картинку после всех шагов генерации.

Negative Prompt — вторая строка для нежелательного. Напишите «bad hands, text» — модель постарается избежать кривых рук и случайных надписей.

Настройки, которые вы контролируете

CFG-scale усиливает соответствие вашему описанию. Значение 7-9 даёт баланс, выше 12 — перенасыщенные цвета и артефакты.

Самплеры определяют способ удаления шума. Euler быстрый, DPM++ SDE Karras детальнее. Для SDXL берите DPM++ — он популярен за скорость и качество.

Количество шагов: 20 хватит для черновика, 30 — для финальной работы. Больше 40 почти не улучшает результат.

Установка на своём ПК: Windows / Mac / Linux

Минимальные требования

Минимум — видеокарта с 6 ГБ памяти и Python 3.10. Этого хватит для SD 1.5 в разрешении 512×512. Для SDXL понадобится 8-10 ГБ.

Если памяти меньше — используйте режим float16. Он снижает точность вычислений, но экономит половину ресурсов без заметной потери качества.

Windows — самый простой путь

AUTOMATIC1111 ставится за пять минут. Скачайте архив sd.webui.zip с GitHub, распакуйте в любую папку и запустите файл run.bat. Откроется командная строка, подождите загрузки — интерфейс появится в браузере.

Первый запуск загрузит все зависимости автоматически. Следующие разы программа стартует за несколько секунд.

Mac и Linux — кроссплатформенный вариант

InvokeAI Launcher работает на всех системах. Инсталлятор сам определит вашу конфигурацию, предложит скачать SDXL-preset и настроит автообновления.

Установка занимает 10-15 минут. Интерфейс современнее, чем у A1111, но функций чуть меньше.

Если видеокарта слабая

Флаги —medvram и —lowvram выгружают часть данных из памяти между шагами. Генерация идёт медленнее, но запустится даже на 4 ГБ.

Библиотека xFormers ускоряет работу на старых GPU. A1111 предложит её установить при первом запуске — соглашайтесь.

SDXL-Turbo генерирует за один шаг вместо 20-30. Качество ниже, зато подходит для быстрых набросков на слабом железе.

Проверка работы

После установки откройте веб-интерфейс, напишите простой запрос вроде «cat in space» и нажмите Generate. Если через минуту появилась картинка — всё настроено правильно.

Облачные варианты: Colab, VK Cloud, Replicate

Когда нужно облако

Нет видеокарты или её мощности не хватает — арендуйте сервер. Вы получаете доступ к профессиональным GPU без покупки железа.

Google Colab — бесплатный старт

Hugging Face выложили готовый ноутбук для запуска SDXL. Откройте ссылку, нажмите «Выполнить все ячейки» — через пять минут можете генерировать.

Результаты сохраняются прямо в Google Drive. Бесплатная версия даёт несколько часов GPU в день, платная Colab Pro снимает ограничения.

Минус — сессия сбрасывается после простоя. Каждый раз придётся запускать заново.

VK Cloud — российский вариант

IaaS-платформа с видеокартами A100 и L40S. По рейтингу CNews тарифы стартуют от 6 ₽ в час — это дешевле, чем зарубежные аналоги.

Вы арендуете виртуальную машину, ставите A1111 или InvokeAI и работаете как на своём ПК. Все настройки и модели сохраняются между сеансами.

Подходит, если нужна стабильная среда для постоянной работы.

Replicate — оплата за картинку

API-сервис без аренды серверов. Вы платите только за сгенерированные изображения — SD 1.5 стоит $0,0039 за кадр, SD 3 — $0,035.

Удобно для разовых задач или интеграции в приложение. Не нужно разбираться с установкой — отправили запрос, получили результат.

Минус — нет доступа к расширенным настройкам вроде ControlNet или своих чекпойнтов.

Как сохранить модели в Colab

Ноутбуки поддерживают загрузку ваших чекпойнтов в Google Drive. Подключите диск к сессии — модели будут доступны при каждом запуске. Web-UI можно открыть по публичной ссылке и работать из браузера.

Быстрый старт в AUTOMATIC1111: txt2img и img2img

Первая генерация за минуту

Откройте вкладку txt2img. В поле Prompt напишите описание — например, «mountain landscape, sunset, dramatic clouds». Настройте базовые параметры: 20-30 шагов, CFG 7-9, выберите самплер DPM++ 2M Karras. Нажмите Generate.

Через 30-60 секунд появится картинка. Если результат не устраивает — меняйте описание или перегенерируйте с другим seed (случайным числом).

Улучшение портретов одной галочкой

Генерируете лица — включите Restore Faces. Модель автоматически исправит глаза, кожу и пропорции. Это убирает типичные артефакты вроде размытых зрачков или странной текстуры.

Работает с любыми настройками, но лучше всего на разрешении 512×512 для SD 1.5 или 1024×1024 для SDXL.

Генерация серий

Batch count создаёт несколько картинок подряд с разными seed. Batch size генерирует сразу пачку за один проход — быстрее, но жрёт больше видеопамяти.

Для экспериментов с вариациями ставьте Batch count 4-8. Так вы получите разные версии одного запроса без лишней нагрузки.

Сохранение настроек

Каждая картинка PNG содержит все параметры генерации в метаданных. Перетащите файл в окно A1111 — настройки автоматически загрузятся в поля. Это упрощает повтор удачных результатов.

Горячие клавиши и расширения

Extension Store в настройках даёт доступ к тысячам плагинов. ControlNet добавляет контроль позы, LoRA Manager упрощает работу со стилями, DreamBooth обучает модель на ваших фото.

Установка плагина — два клика. Перезапустите интерфейс — новые функции появятся в меню.

Базовый prompt-паттерн: субъект + стиль + детали

Структурируйте описание по схеме: главный объект → действие → окружение → стиль → освещение. Например: «elderly wizard, casting spell, ancient library, oil painting style, warm candlelight».

Такой порядок даёт предсказуемый результат. Модель сначала поймёт, кто главный герой, потом что он делает, где находится и как всё должно выглядеть.

Порядок слов имеет значение

Последние слова в prompt получают больший вес. Если напишете «cat, space, astronaut» — акцент будет на космонавте. Напишете «astronaut, space, cat» — кот станет центром композиции.

Используйте это для управления приоритетами. Самое важное ставьте ближе к концу описания.

Управление весом слов

Двойное двоеточие :: усиливает влияние блока. Запись «red car::1.5» сделает красный цвет более насыщенным. Значение 0.5-1.5 даёт тонкую настройку, выше 2.0 — перенасыщение и артефакты.

Negative Prompt — что убрать

Вторая строка для нежелательного. Стандартный набор: «bad hands, text, watermark, blurry, low quality». Это убирает типичные дефекты.

Для портретов добавьте «distorted face, extra fingers». Для пейзажей — «people, buildings», если хотите природу без цивилизации.

Пример влияния порядка

Один и тот же набор слов даёт разные результаты:

- «sunset, beach, palm tree» — закат главный, пляж фоном

- «palm tree, beach, sunset» — дерево на переднем плане, закатное освещение

- «beach scene, sunset lighting, palm tree detail» — сбалансированная композиция

Экспериментируйте с перестановкой — это бесплатно и быстро.

Продвинутые фишки: LoRA, ControlNet, Inpaint

LoRA — быстрая смена стиля

LoRA — это небольшие файлы-дополнения, которые меняют стиль генерации. Один LoRA превращает всё в аниме, другой — в акварель, третий — в киберпанк.

Скачайте нужный файл, положите в папку models/Lora. В интерфейсе A1111 кликните по иконке LoRA — появится список доступных. Клик вставляет тег вроде <lora:anime_style:0.7> прямо в prompt.

Цифра в конце — сила влияния. Значение 0.7-1.1 даёт заметный эффект без искажений. Ниже 0.5 — еле видно, выше 1.5 — перебор и артефакты.

ControlNet — контроль композиции

ControlNet фиксирует позу, контуры или глубину сцены. Загрузите референсное фото — модель повторит его структуру, но с вашим стилем.

OpenPose извлекает скелет персонажа. Вы показываете фото танцора — получаете ту же позу, но в средневековых доспехах или футуристическом костюме.

Canny определяет контуры объектов. Набросок карандашом превращается в детальную иллюстрацию.

Установите расширение через Extension Store, перезапустите интерфейс — вкладка ControlNet появится под полем prompt.

Inpaint — точечная правка

Генерация не идеальна — иногда нужно исправить фрагмент. Inpaint перерисовывает выделенную область, оставляя остальное без изменений.

Загрузите картинку во вкладку img2img → Inpaint. Кистью закрасьте проблемное место — кривую руку, лишний объект, неудачный фон. В prompt опишите, что хотите вместо этого.

Mask Blur 4-8 пикселей сглаживает границы правки. Без размытия будет заметный шов между старым и новым.

SDXL Refiner — финальная полировка

Refiner — вторая модель для улучшения деталей. Сгенерируйте базовую картинку обычной SDXL, затем прогоните через Refiner.

Он вытягивает текстуры, исправляет мелкие артефакты, делает текст читаемее. Особенно полезен для изображений 1024×1024 — разница заметна на мелочах вроде складок ткани или листьев деревьев.

Кейсы: дизайн, маркетинг, разработка игр

Студии формируют визуальный стиль игры за часы вместо недель. Генерируете десятки вариантов персонажей, локаций, оружия — выбираете лучшее и дорабатываете вручную. Сториборды для катсцен создаются так же быстро, режиссёр видит раскадровку до начала производства.

Маркетологи запускают A/B-тесты с десятками обложек для одного поста. Генерация занимает минуты — тестируете разные стили, цвета, композиции без дизайнера. Результат показывает, какая картинка цепляет аудиторию, победителя отдаёте на финальную доработку.

Художники генерируют PBR-карты и бесшовные плитки для Unity и Unreal Engine прямо в A1111. ControlNet помогает создать нужный паттерн, Inpaint убирает швы на стыках. Один художник закрывает задачи, на которые раньше уходила неделя команды.

Агентства делают мокапы рекламных роликов в SDXL-Turbo для быстрой защиты концепта. Генерируют ключевые кадры за минуты — клиент видит идею до съёмок. Если концепт не заходит — правите без затрат на продакшн.

Лайфхаки экономии VRAM и времени

Включите VAE tiled и half-precision в настройках A1111. Это снижает потребление памяти почти вдвое без заметной потери качества. Картинки выглядят так же, но генерация идёт на слабом железе.

Флаги —lowvram и —medvram запускаются через командную строку. Они выгружают веса модели между шагами, освобождая видеопамять. Генерация замедляется на 20-30%, зато работает даже на 4 ГБ.

SDXL-Turbo создаёт черновики за 1-4 шага вместо 20-30. Качество ниже финального, но подходит для быстрого перебора идей. При этом требует всего 1-2 ГБ VRAM — запустится на любой карте.

Библиотека Diffusers поддерживает флаг —sd_cpu_offload. Он перемещает часть вычислений на процессор, освобождая видеокарту. Полезно, если у вас мощный CPU, но слабая GPU.

Лицензия, безопасность и этика

Лицензия CreativeML Open RAIL-M разрешает коммерческое использование модели. Вы можете генерировать картинки для продажи, включать в продукты, использовать в рекламе. Но есть ограничения — запрещён контент для взрослых без фильтров, дипфейки публичных лиц без их согласия и поддельные логотипы брендов.

Web-UI автоматически записывает все параметры генерации в метаданные PNG. Там сохраняется prompt, seed, модель, настройки. Это упрощает аудит — вы всегда можете доказать, как создана картинка.

TechCrunch напоминает о рисках открытых весов. Модель можно использовать для создания несанкционированного контента — дипфейков политиков, поддельных новостей, фейковых фото. Разработчики обязаны внедрять фильтры и проверки перед публикацией инструментов.

Проверяйте стоковые базы перед использованием чужих изображений в обучении. Избегайте брендов в генерации — Nike, Apple, Coca-Cola защищены авторским правом. Храните приватные данные локально или в закрытых каналах, не загружайте в публичные сервисы.

Что дальше: SD 4 и realtime-рендер

Stability AI анонсирует переход к SD 4 с единым контролем персонажей и рендером за 4 шага или меньше. Это означает генерацию в реальном времени — изменили prompt, через секунду видите результат.

Stable Video Diffusion и Virtual Camera уже превращают статичный кадр в 3D-видео с управлением камерой. Загружаете одну картинку — получаете облёт объекта под разными углами или движение персонажа.

Оптимизации в библиотеке Diffusers готовят SD к запуску на смартфонах. Device_map и quantization снижают требования к памяти настолько, что модель работает на мобильных чипах. Скоро генерация будет доступна в AR-приложениях без подключения к интернету.

Open-weights-экосистема расширяется за пределы картинок. Cascades улучшает разрешение до 4K и выше, 3D-генерация создаёт объекты для игровых движков, ControlNet-плагины добавляют контроль освещения и материалов. SD становится универсальным инструментом для любого визуального контента.

Главное о Stable Diffusion

Stable Diffusion — открытая нейросеть для генерации изображений по текстовому описанию. Главное отличие от Midjourney и DALL·E — полная свобода: скачиваете на свой ПК, запускаете бесплатно, настраиваете все параметры. Минимальные требования — видеокарта с 6 ГБ памяти. Если железа нет — используйте Google Colab бесплатно или арендуйте GPU в VK Cloud от 6 ₽/час. Лицензия разрешает коммерческое использование, но запрещает дипфейки и поддельные бренды.

Для работы достаточно установить AUTOMATIC1111 — интерфейс запускается за пять минут. Пишете описание в формате «субъект + стиль + детали», выбираете 20-30 шагов и CFG 7-9. Продвинутые инструменты — LoRA для смены стиля, ControlNet для контроля позы, Inpaint для точечных правок. Модель развивается быстро: SD 3.5 генерирует качественный текст и детали, SD 4 обещает realtime-рендер за 4 шага. Открытый код породил тысячи расширений — SD стала стандартом для дизайна, маркетинга и разработки игр.